基于Ollama快速本地部署DeepSeek

在这篇文章中,我将基于

Ollama,在Windows和Ubuntu系统中快速部署DeepSeek当然,要想使用响应更快速、效果更优秀的模型,还是需要更好的

GPU来支持的

Ollama的下载与安装

Ollama是一个轻量级的工具,可以帮助你在本地快速部署和运行大语言模型

Windows

点击进入Ollama官网下载Ollama Download Ollama

Ubuntu

# 输入如下命令安装ollama

curl -fsSL https://ollama.com/install.sh | shDeepSeek模型的下载运行

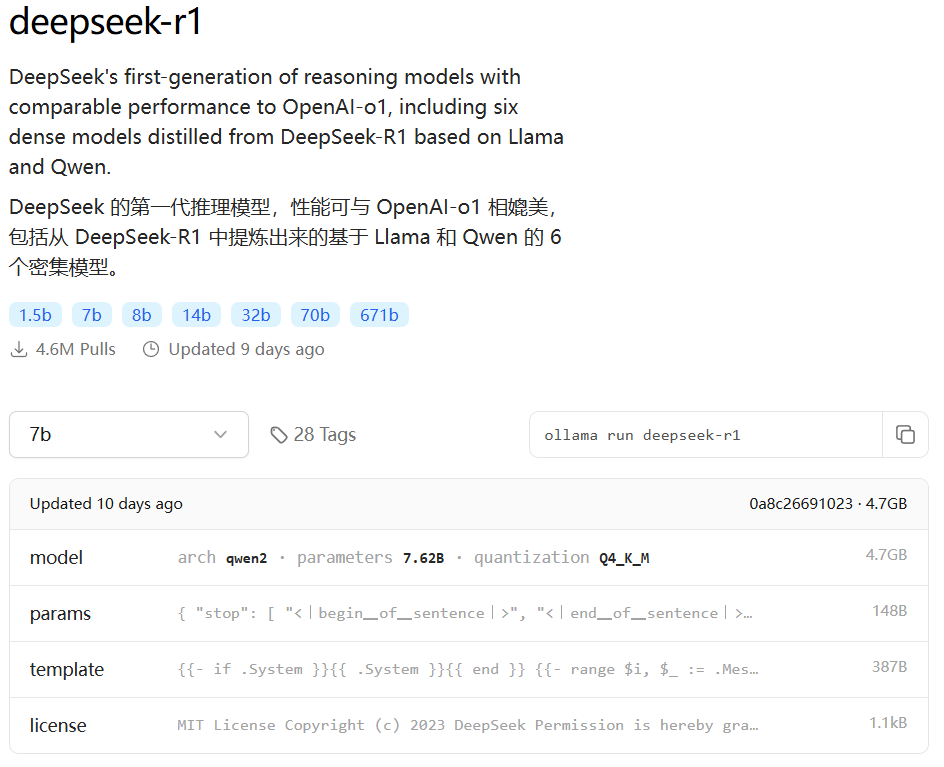

Ollama安装完成后打开终端,根据需要选择安装模型 DeepSeek模型列表

在终端输入如下命令即可完成安装并运行

# Default 7B model (4.7GB - ideal for consumer GPUs)

ollama run deepseek-r1

# Larger 70B model (requires 24GB+ VRAM)

ollama run deepseek-r1:70b

# Actual DeepSeek-R1 (requires 336GB+ VRAM for 4-bit quantization)

ollama run deepseek-r1:671b提示

下载速度很快,若下载速度降低可以取消后再次输入命令,有断点续传功能,速度可以再次跑满

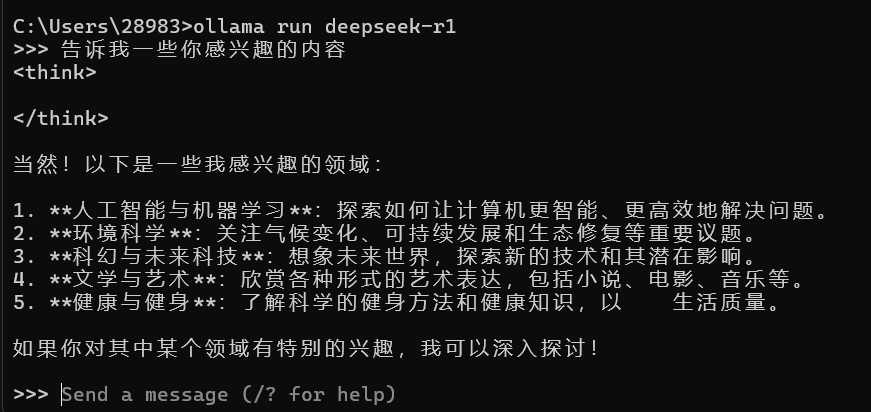

DeepSeek-r1 效果

导航

DeepSeek Github

DeepSeek配置要求 PC端 完全本地部署deepseek的配置要求

Open WebUI Github